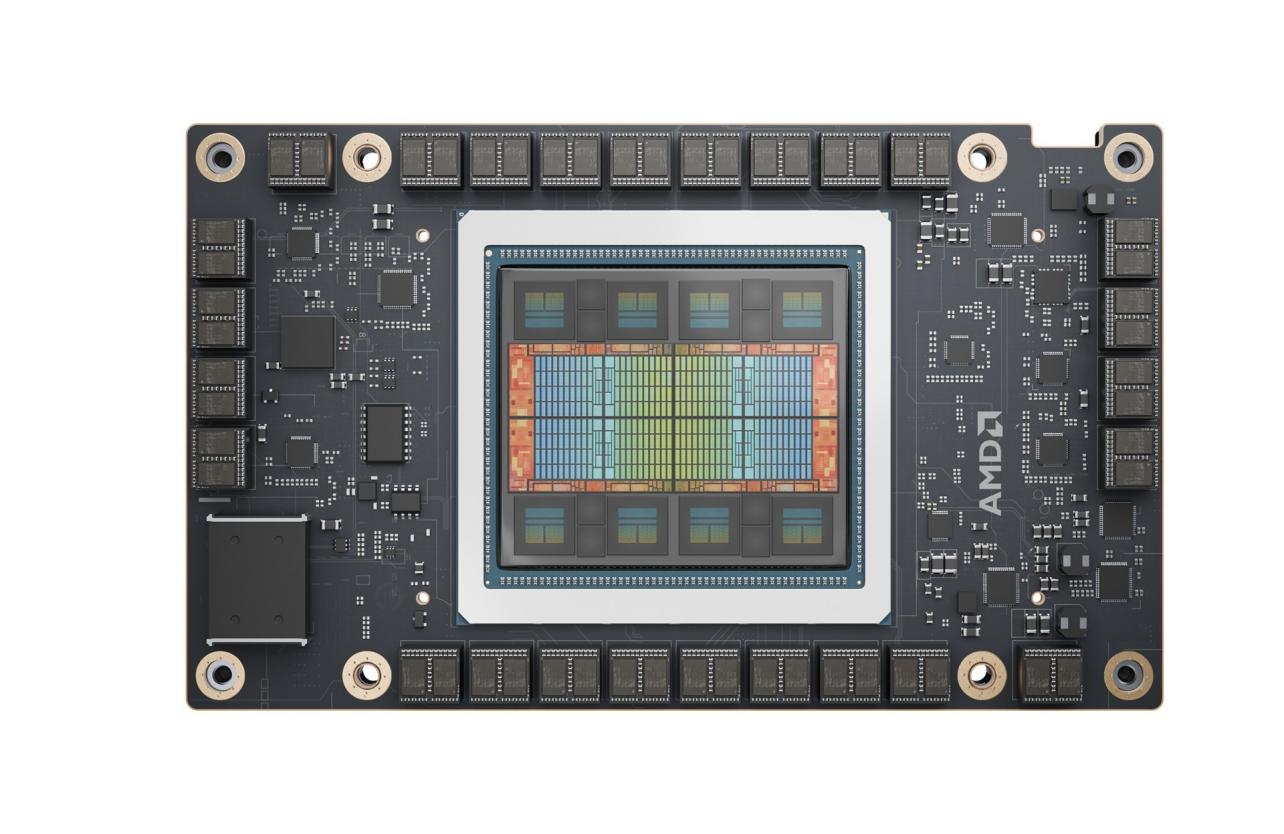

AMD Advancing AI 2024大会于近日正式拉开帷幕,除了备受关注的新一代EPYC之外,AMD硬刚NVIDIA的Instinct MI300系列AI加速器也正式放出了两款新品的规格与性能信息,包括MI325X和MI355X。二者在基础规格和性能层面相比MI300X都有了显著提升。

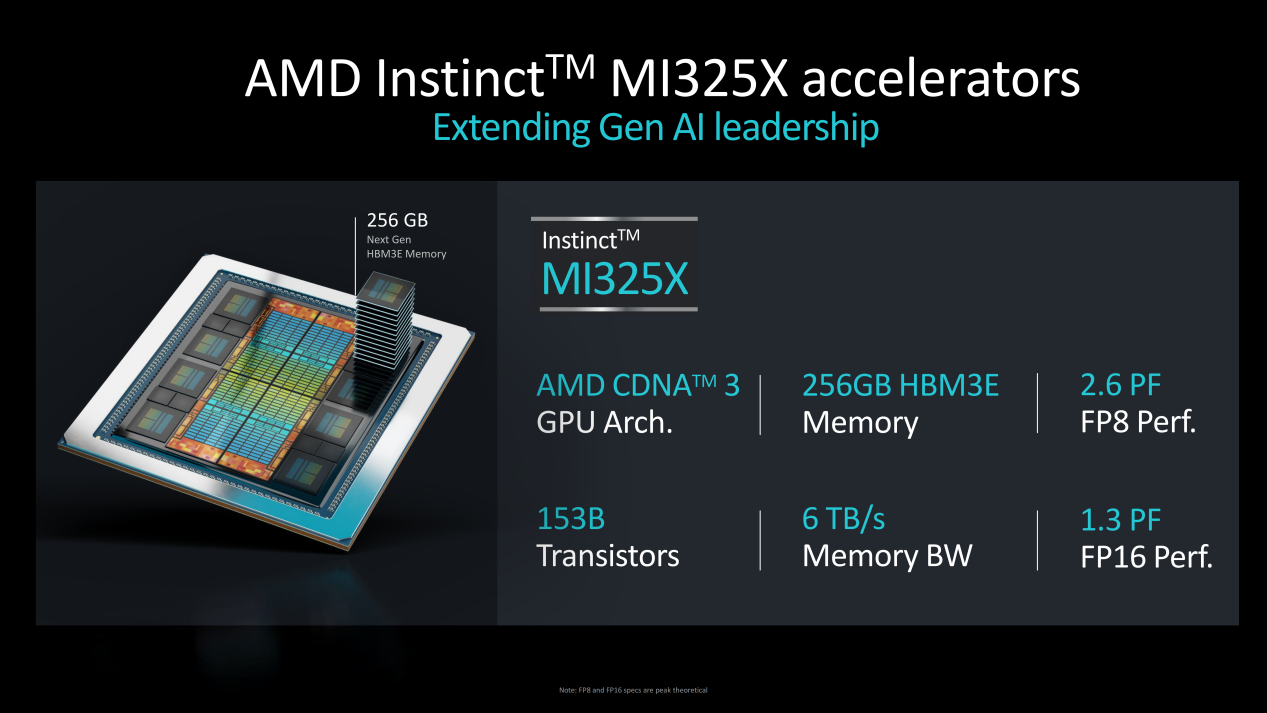

首先来看MI325X,它基于AMD CDNA3 GPU架构打造,拥有1530亿晶体管,支持256GB HBM3E存储,提供6TB/s高速带宽,FP8算力达到2.6PF,FP16算力达到1.3PF。

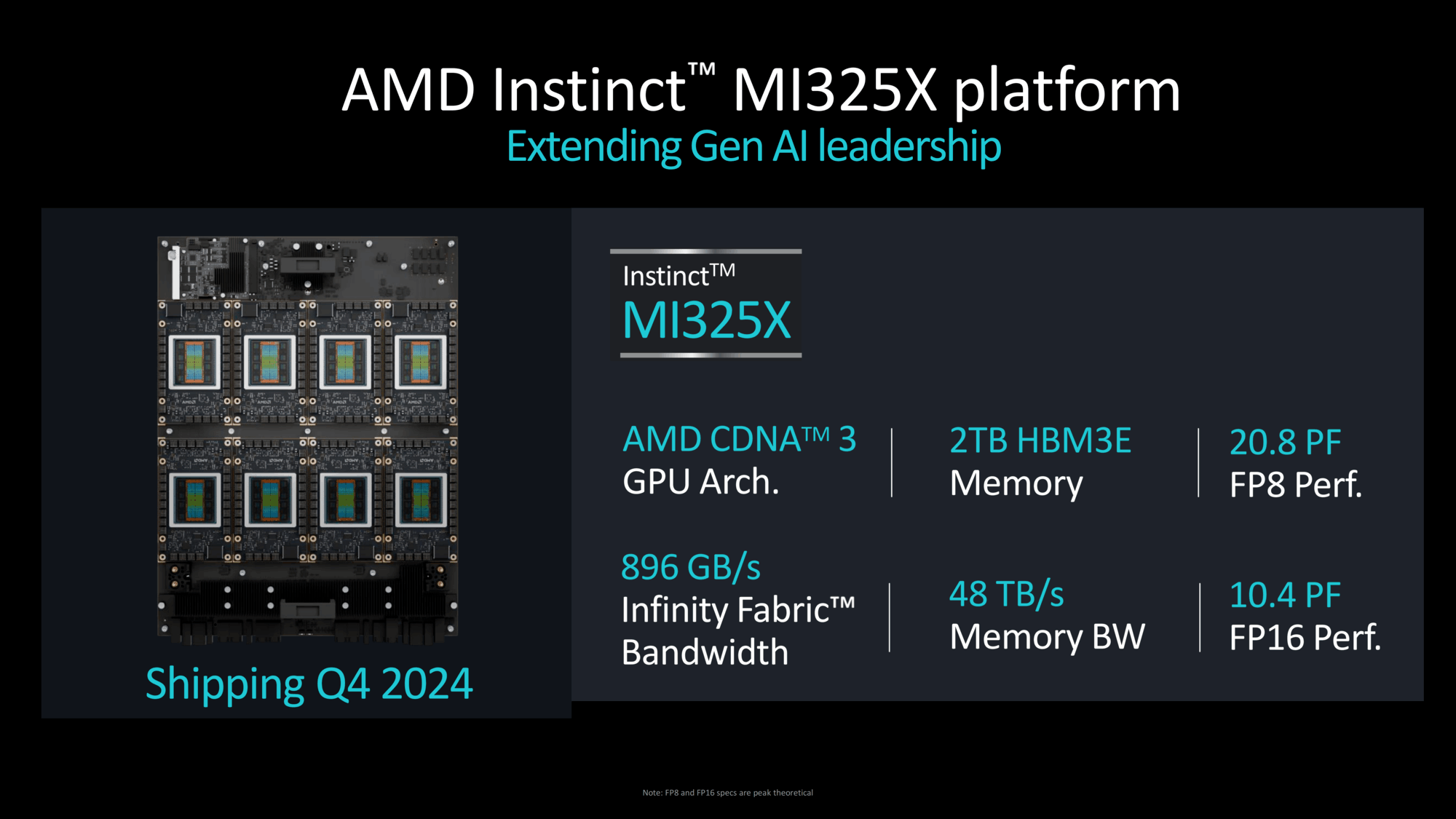

Instinct MI325X平台总计支持2TB HBM3E存储,带宽速率达到48TB/s,Infinity Fabric带宽速率达到896G/s,总计能够提供高达20.8PF的FP8算力和10.4PF的FP16算力,整体性能可以说是非常不错。

Instinct MI325X平台总计支持2TB HBM3E存储,带宽速率达到48TB/s,Infinity Fabric带宽速率达到896G/s,总计能够提供高达20.8PF的FP8算力和10.4PF的FP16算力,整体性能可以说是非常不错。

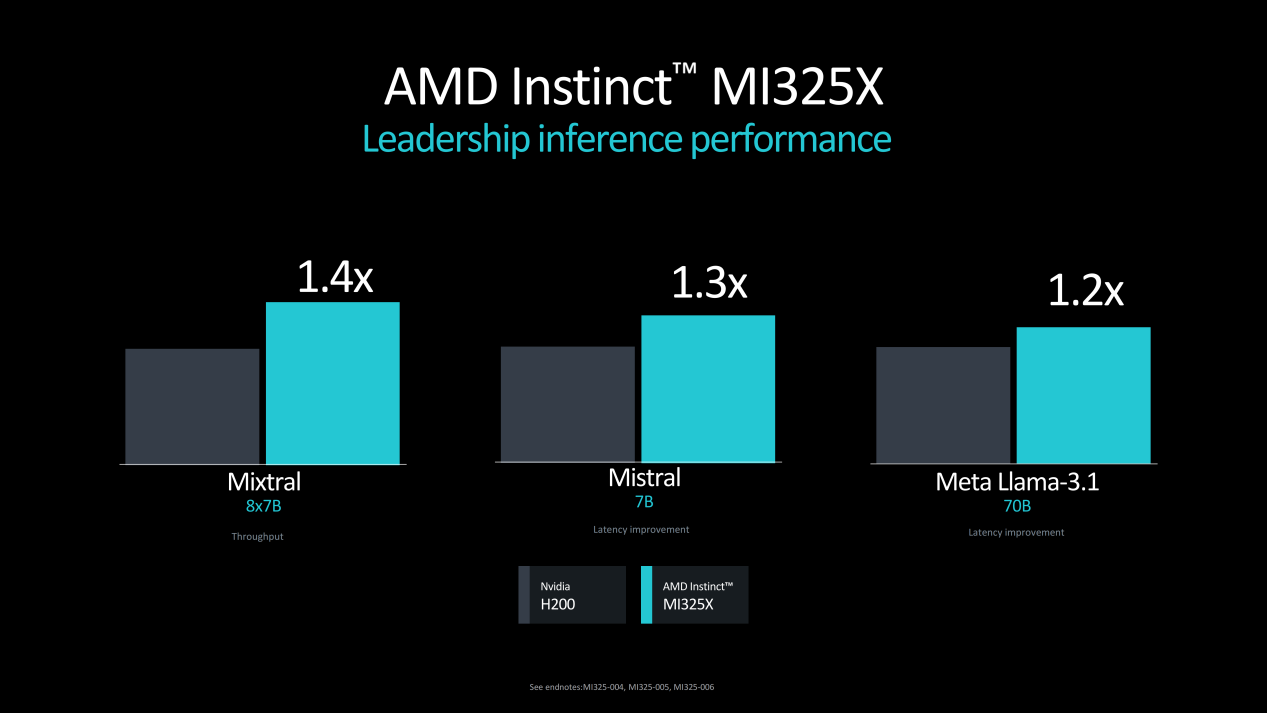

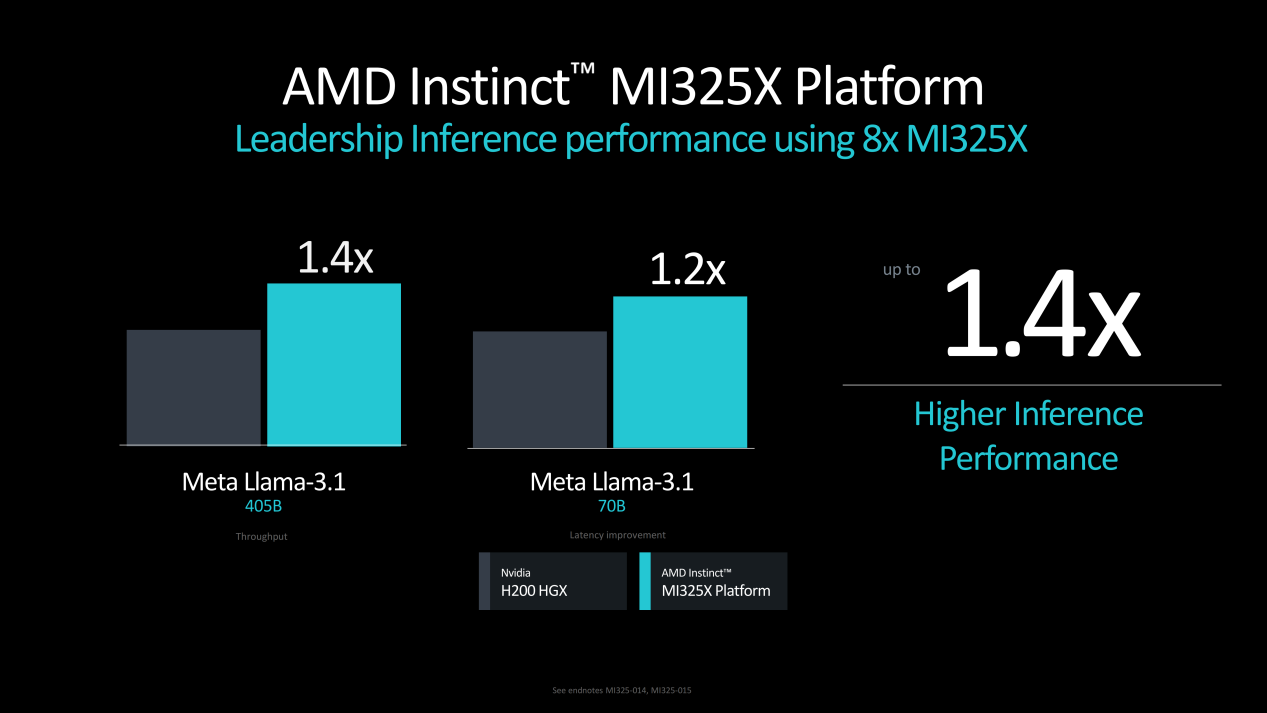

性能方面,Instinct MI325X对比NVIDIA H200,Mixtral 8x7B大模型吞吐量是竞品的1.4倍,Mixtral 7B大模型数据吞吐延迟改善1.3倍,Meta Llama-3.1 70B大模型数据吞吐延迟改善1.2倍,AI大模型效率更加出色。

性能方面,Instinct MI325X对比NVIDIA H200,Mixtral 8x7B大模型吞吐量是竞品的1.4倍,Mixtral 7B大模型数据吞吐延迟改善1.3倍,Meta Llama-3.1 70B大模型数据吞吐延迟改善1.2倍,AI大模型效率更加出色。

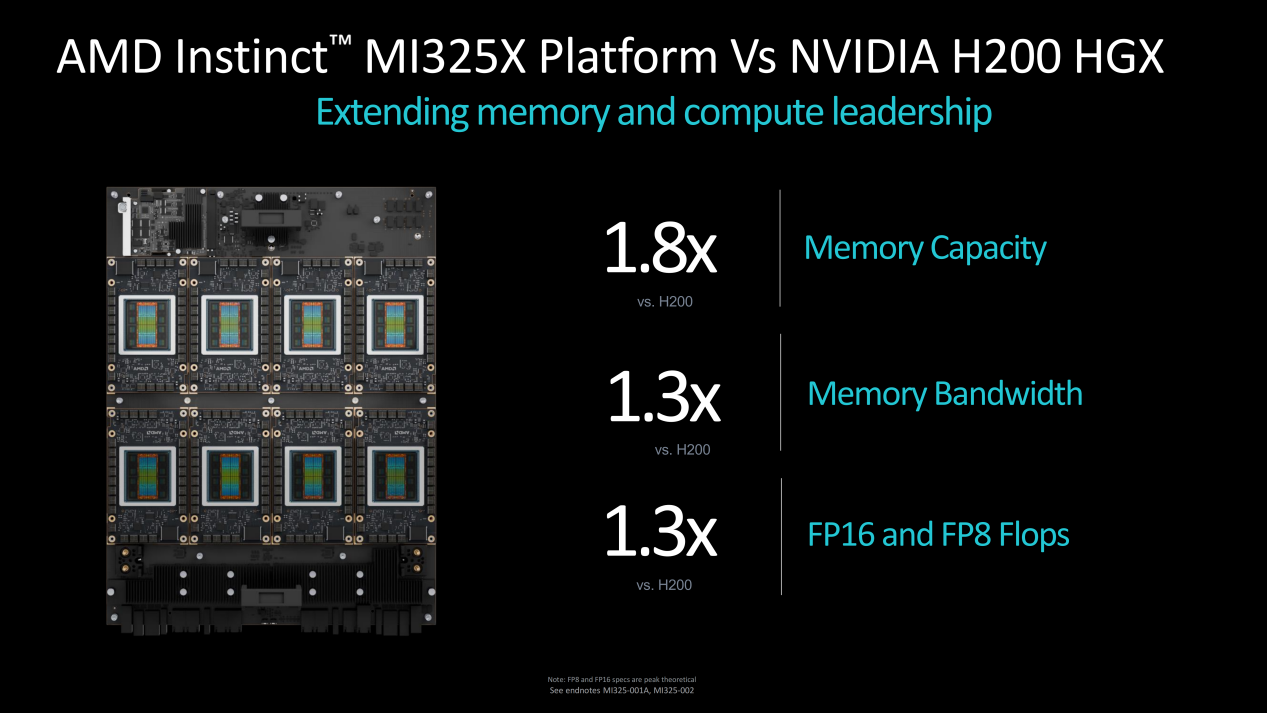

存储方面对比NVIDIA H200 HGX平台,Instinct MI325X平台存储容量是竞品的1.8倍,存储带宽是其1.3倍,FP16以及FP8浮点算力是其1.3倍,更快更强。

存储方面对比NVIDIA H200 HGX平台,Instinct MI325X平台存储容量是竞品的1.8倍,存储带宽是其1.3倍,FP16以及FP8浮点算力是其1.3倍,更快更强。

此外,Instinct MI325X相比NVIDIA H200 HGX平台整体性能提升了1.4倍,在Meta Llama-3.1 405B大模型和Meta Llama-3.1 70B大模型的算力方面分别是竞品的1.4倍和1.2倍。

此外,Instinct MI325X相比NVIDIA H200 HGX平台整体性能提升了1.4倍,在Meta Llama-3.1 405B大模型和Meta Llama-3.1 70B大模型的算力方面分别是竞品的1.4倍和1.2倍。

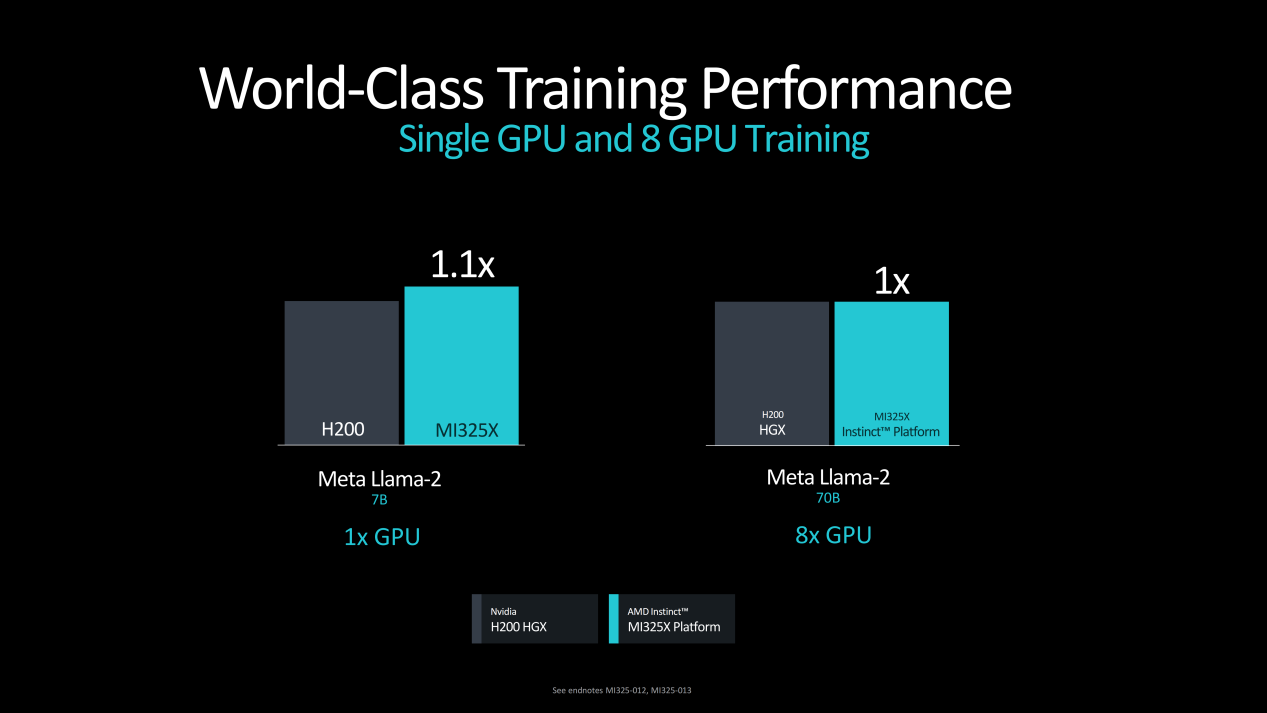

此外在大模型训练方面,Instinct MI325X平台也将为客户提供世界级的尖端性能体验。在Meta Llama-2 7B大模型训练方面,Instinct MI325X单GPU性能是NVIDIA H200 HGX的1.1倍,8xGPU在MetaLlama-2 70B大模型训练上的性能与竞品持平。

此外在大模型训练方面,Instinct MI325X平台也将为客户提供世界级的尖端性能体验。在Meta Llama-2 7B大模型训练方面,Instinct MI325X单GPU性能是NVIDIA H200 HGX的1.1倍,8xGPU在MetaLlama-2 70B大模型训练上的性能与竞品持平。

根据AMD官方信息,Instinct MI325X平台将于2024年第四季度正式投产,2025年一季度开始将获得众多系统和基础设备解决方案合作伙伴的鼎力支持。

根据AMD官方信息,Instinct MI325X平台将于2024年第四季度正式投产,2025年一季度开始将获得众多系统和基础设备解决方案合作伙伴的鼎力支持。

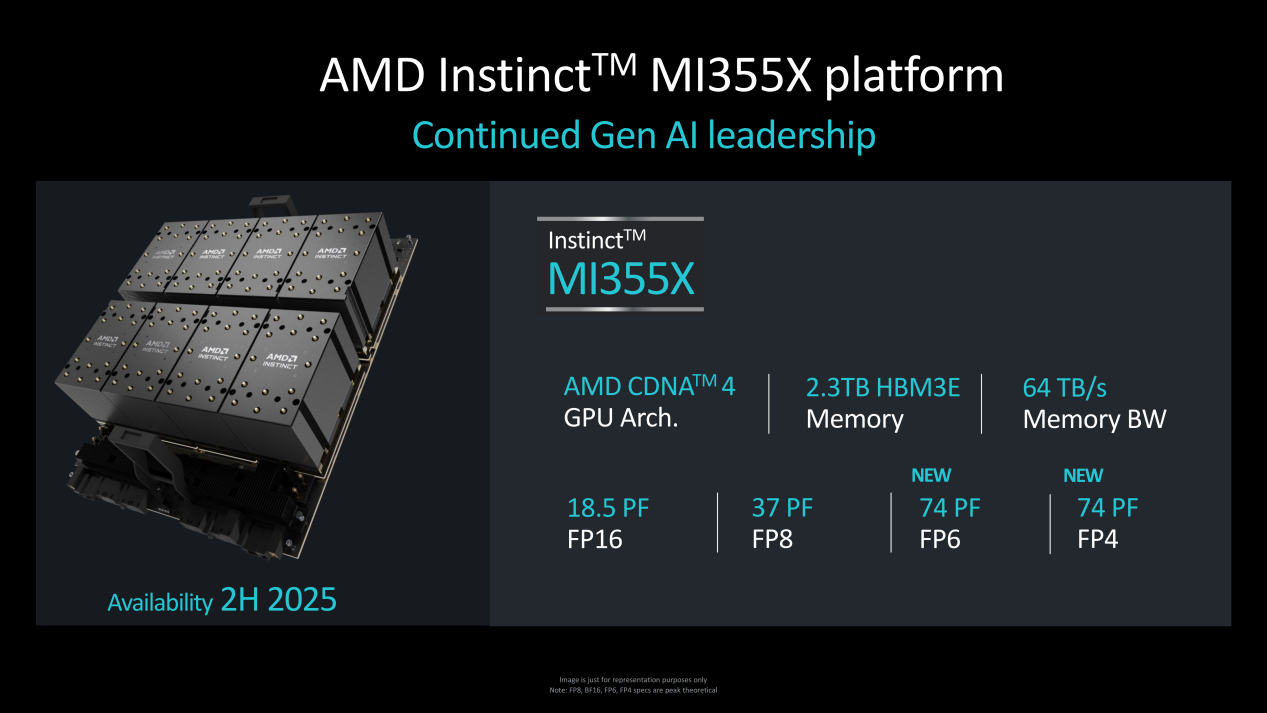

相比很快就能见到的Instinct MI325X而言,Instinct MI350系列则要等到2025年才能正式推出。该系列芯片将采用全新的CDNA4架构设计,基于3nm制程工艺打造,HBM3E存储容量将提升至288GB,并全新支持FP4/FP6数据类型。

相比很快就能见到的Instinct MI325X而言,Instinct MI350系列则要等到2025年才能正式推出。该系列芯片将采用全新的CDNA4架构设计,基于3nm制程工艺打造,HBM3E存储容量将提升至288GB,并全新支持FP4/FP6数据类型。

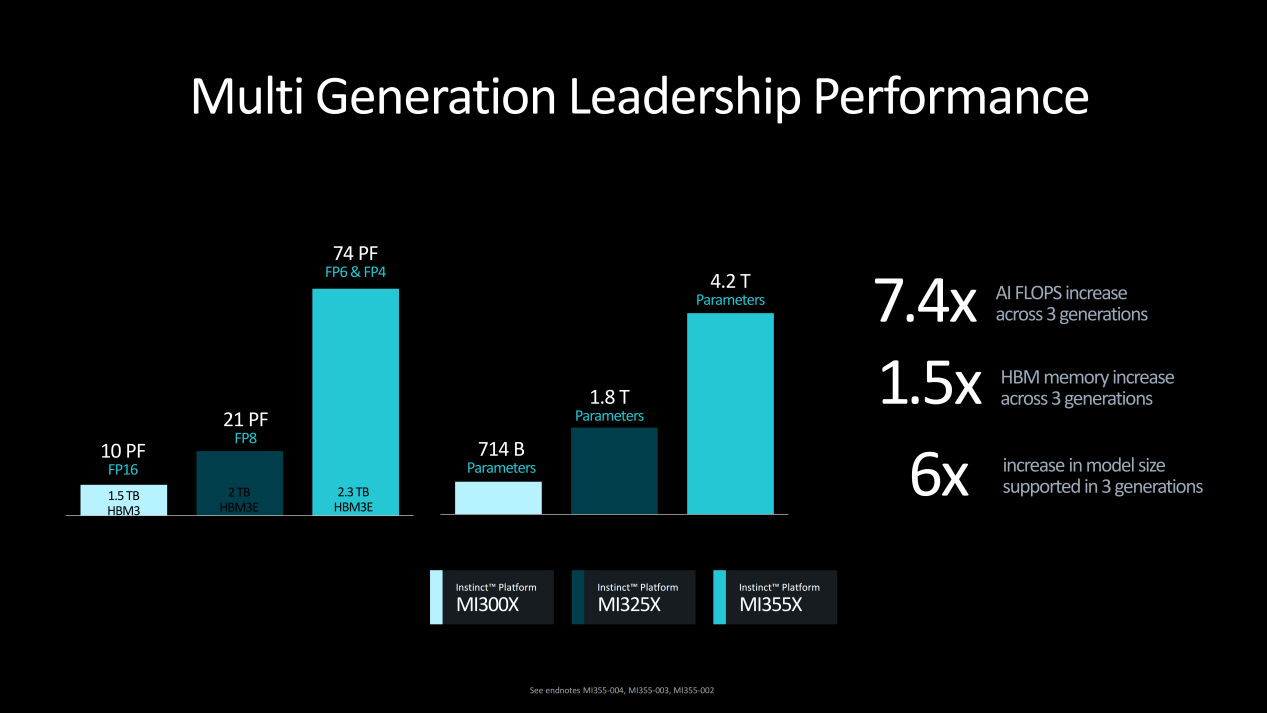

Instinct MI350系列的重点型号为Instinct MI355X,整个平台拥有2.3TB HBM3E存储空间,并且有着高达64TB/s的存储带宽,FP16/FP8算力分别可达18.5PF和37PF,同时在FP6/FP4数据类型上可提供74PF的超高算力支持。

Instinct MI350系列的重点型号为Instinct MI355X,整个平台拥有2.3TB HBM3E存储空间,并且有着高达64TB/s的存储带宽,FP16/FP8算力分别可达18.5PF和37PF,同时在FP6/FP4数据类型上可提供74PF的超高算力支持。

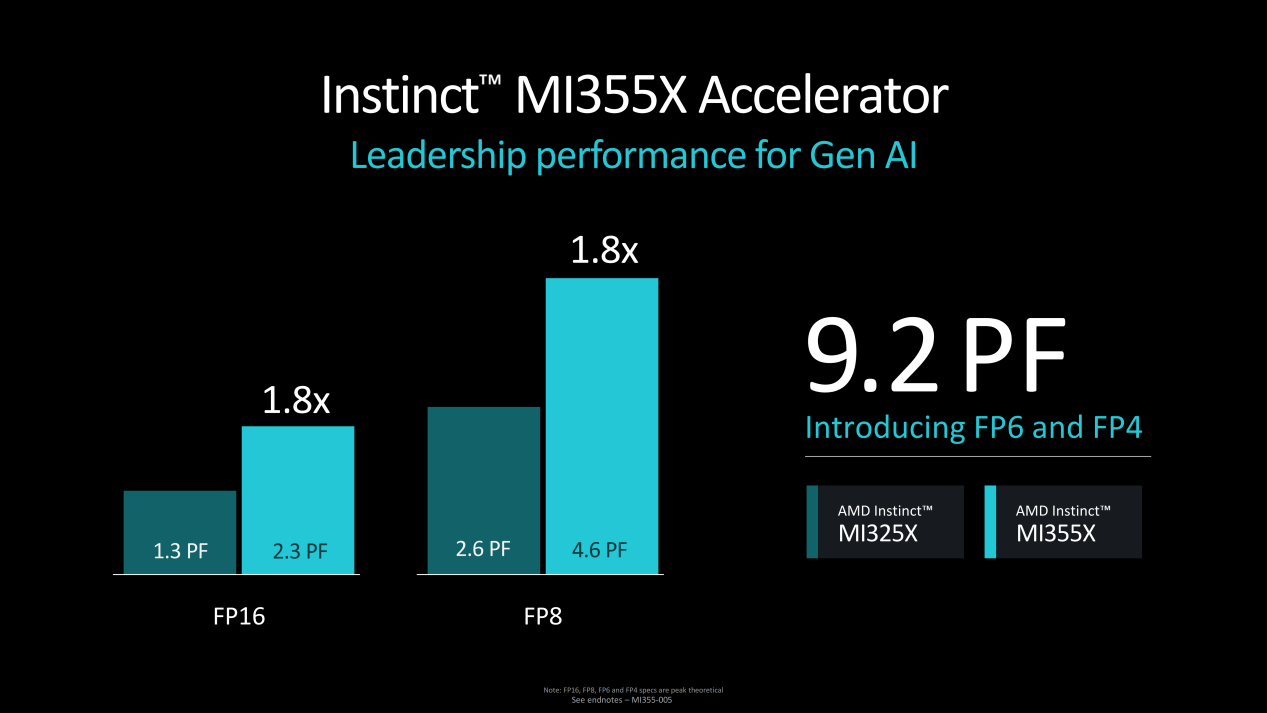

性能层面,Instinct MI355X表现相当强力。对比Instinct MI325X,其在FP16/FP8性能方面分别是其1.8倍,单卡FP6/FP4算力达到9.2PF。

性能层面,Instinct MI355X表现相当强力。对比Instinct MI325X,其在FP16/FP8性能方面分别是其1.8倍,单卡FP6/FP4算力达到9.2PF。

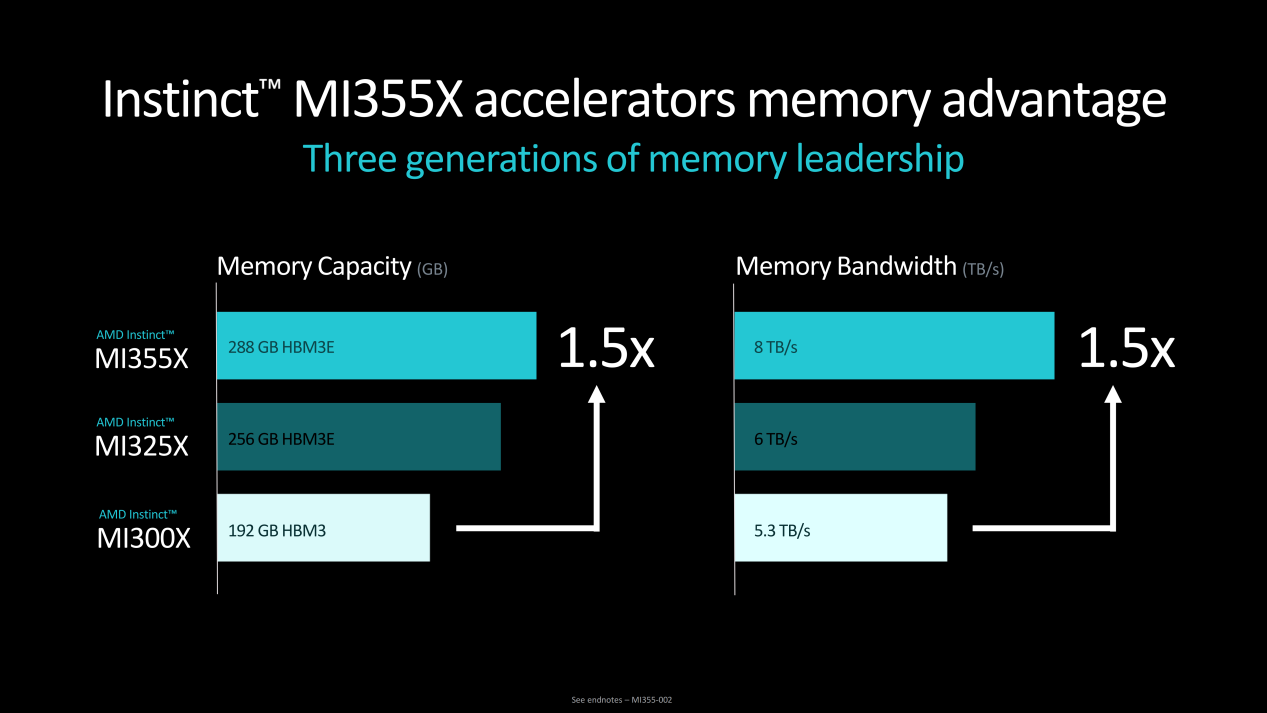

存储方面对比Instinct MI300。Instinct MI355X在存储容量和存储带宽速率上均提升了1.5倍,同时也比Instinct MI325X规格更高。

性能与存储的巨大提升,使得Instinct MI355X在AI浮点计算、HBM存储以及可支持的大模型规模方面,3代产品对比最高分别提升7.4倍、1.5倍以及6倍。

性能与存储的巨大提升,使得Instinct MI355X在AI浮点计算、HBM存储以及可支持的大模型规模方面,3代产品对比最高分别提升7.4倍、1.5倍以及6倍。

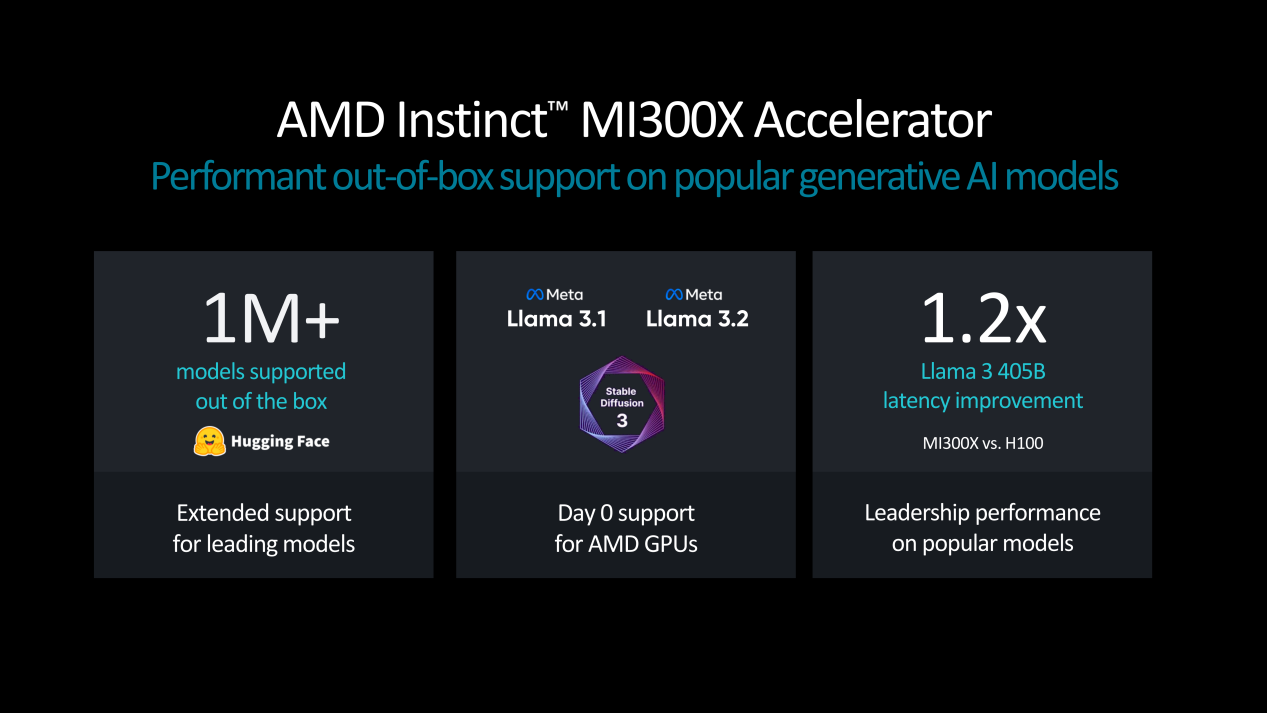

在强力硬件基础之上,AMD针对AI大模型的适配、优化支持也更加出色。Hugging face大模型支持量超过100万个,Meta Llama 3.1/3.2实现Day0支持,并且大幅改善了大模型数据吞吐延迟。

在强力硬件基础之上,AMD针对AI大模型的适配、优化支持也更加出色。Hugging face大模型支持量超过100万个,Meta Llama 3.1/3.2实现Day0支持,并且大幅改善了大模型数据吞吐延迟。

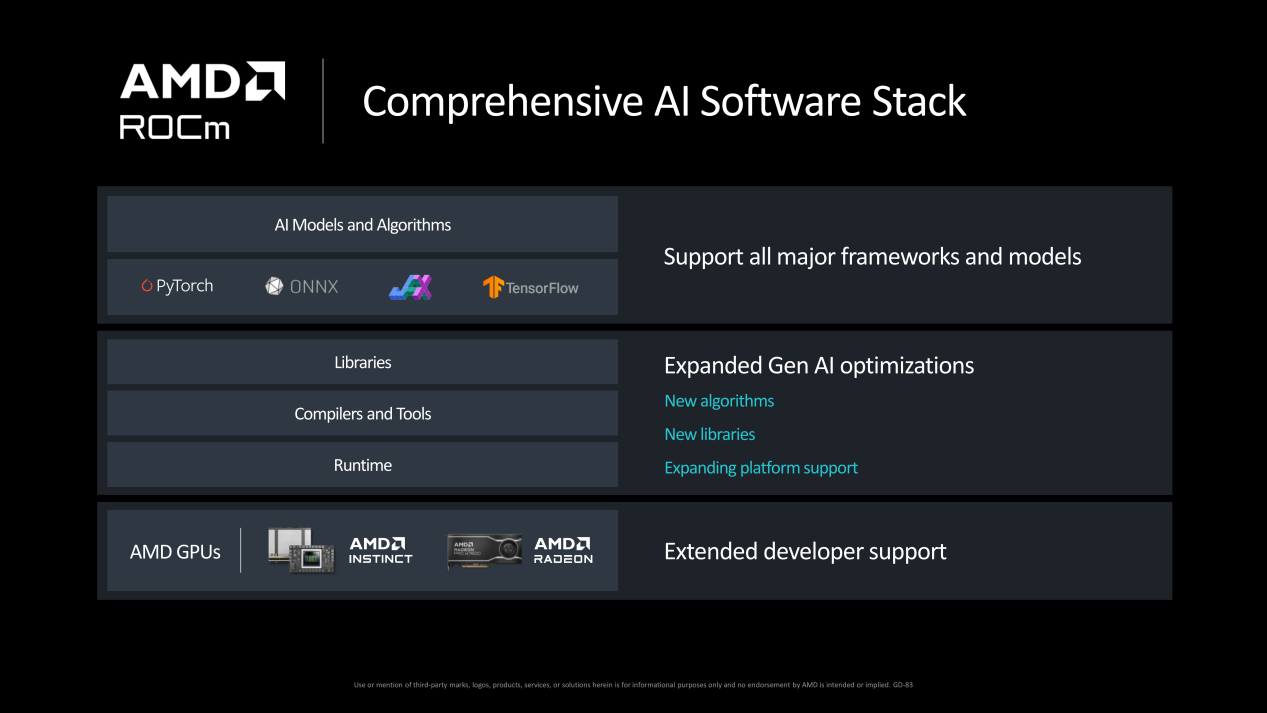

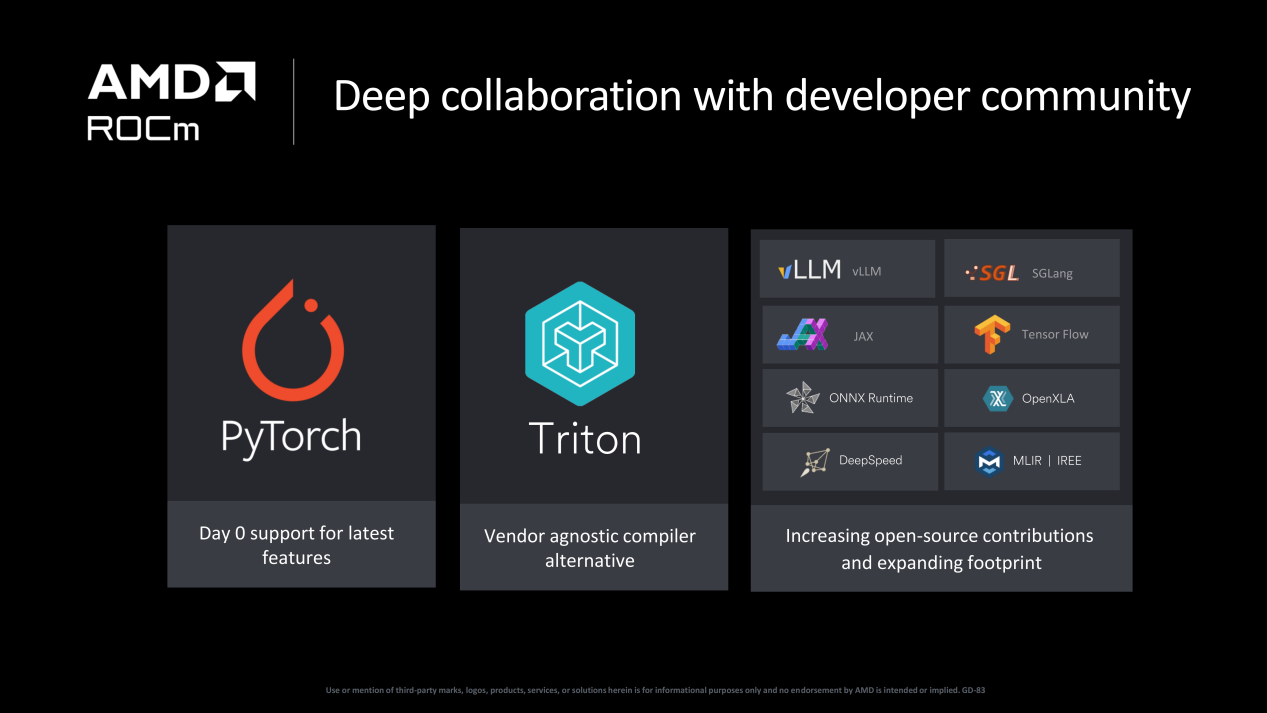

而在AI软件栈的构建上也相当完善。支持所有主要框架和模型,如PyTorch、ONNX。在库、编译器和工具以及Runtime方面,通过新的算法和新的库实现进一步拓展与支持。

而在AI软件栈的构建上也相当完善。支持所有主要框架和模型,如PyTorch、ONNX。在库、编译器和工具以及Runtime方面,通过新的算法和新的库实现进一步拓展与支持。

此外在ROCm软件栈方面也积极与社区开发者们深度合作,并对多个开源社区做出贡献。

此外在ROCm软件栈方面也积极与社区开发者们深度合作,并对多个开源社区做出贡献。

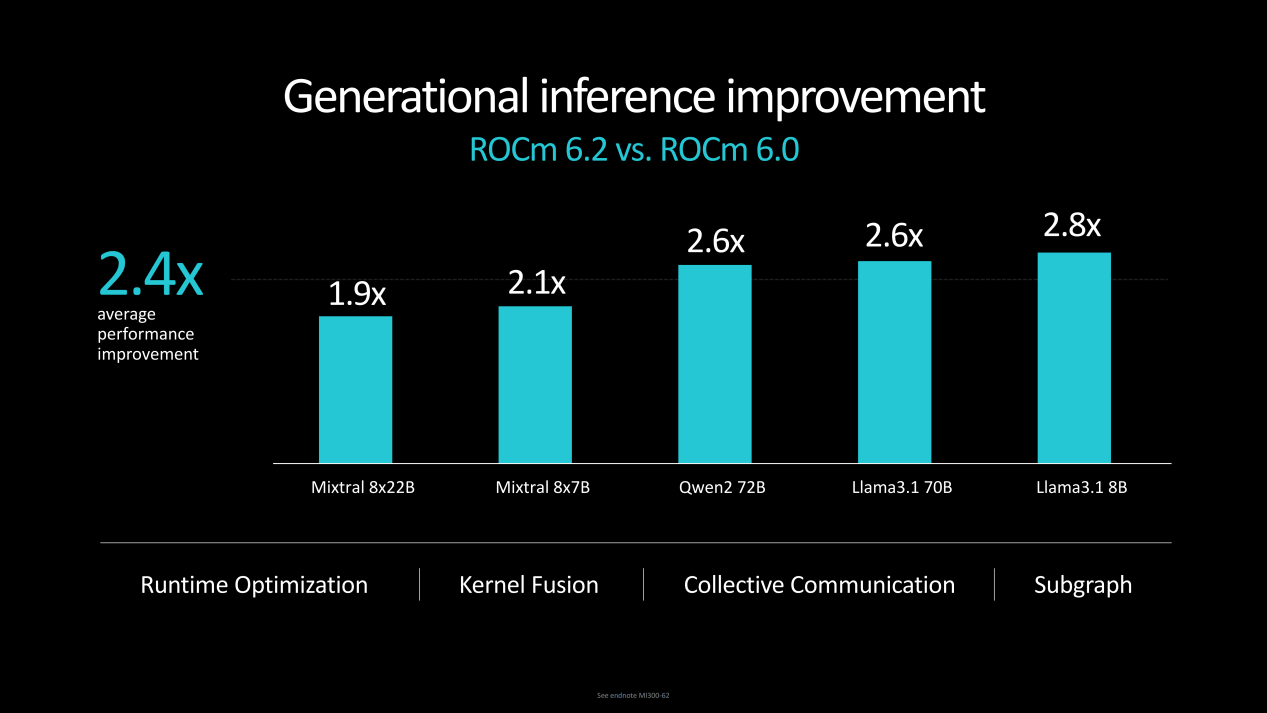

在ROCm6.2与6.0的多个大模型推理性能方面,代际平均提升2.4倍,最高提升2.8倍。

在ROCm6.2与6.0的多个大模型推理性能方面,代际平均提升2.4倍,最高提升2.8倍。

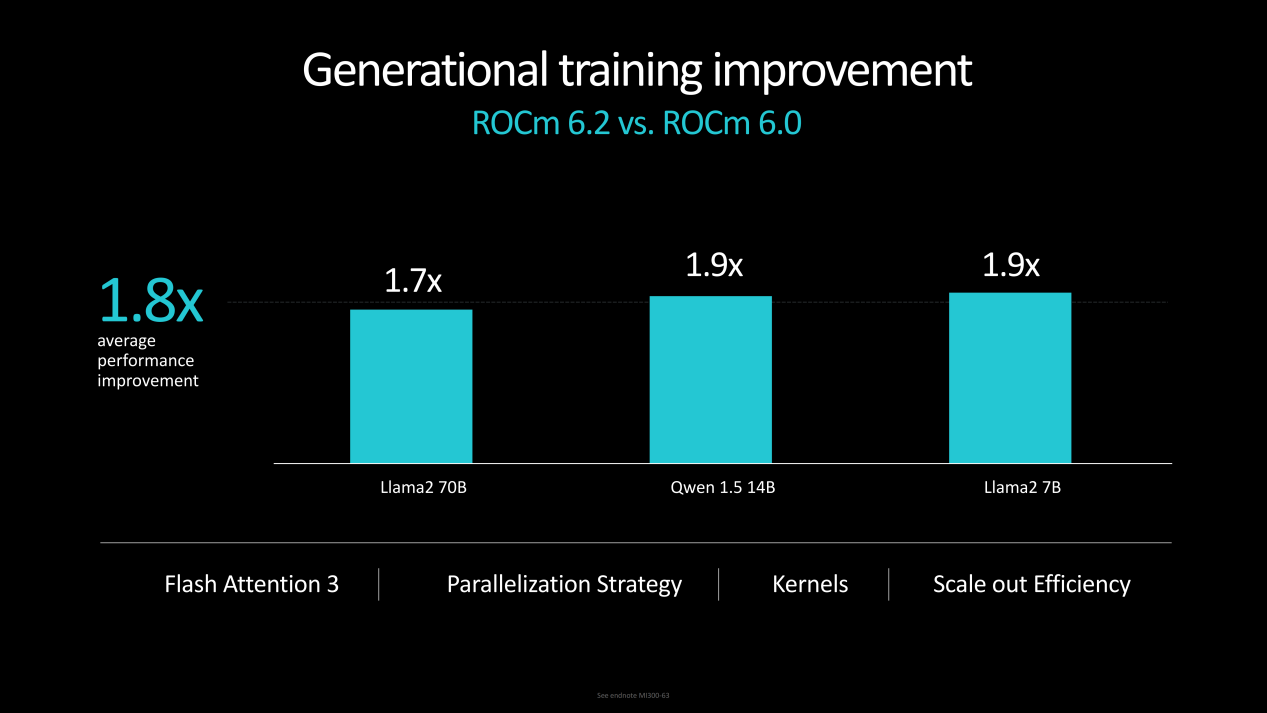

在ROCm6.2与6.0的Llama2 70B、Qwen1.5 14B、Llama2 7B大模型训练方面,代际性能平均提升1.8倍。

在ROCm6.2与6.0的Llama2 70B、Qwen1.5 14B、Llama2 7B大模型训练方面,代际性能平均提升1.8倍。

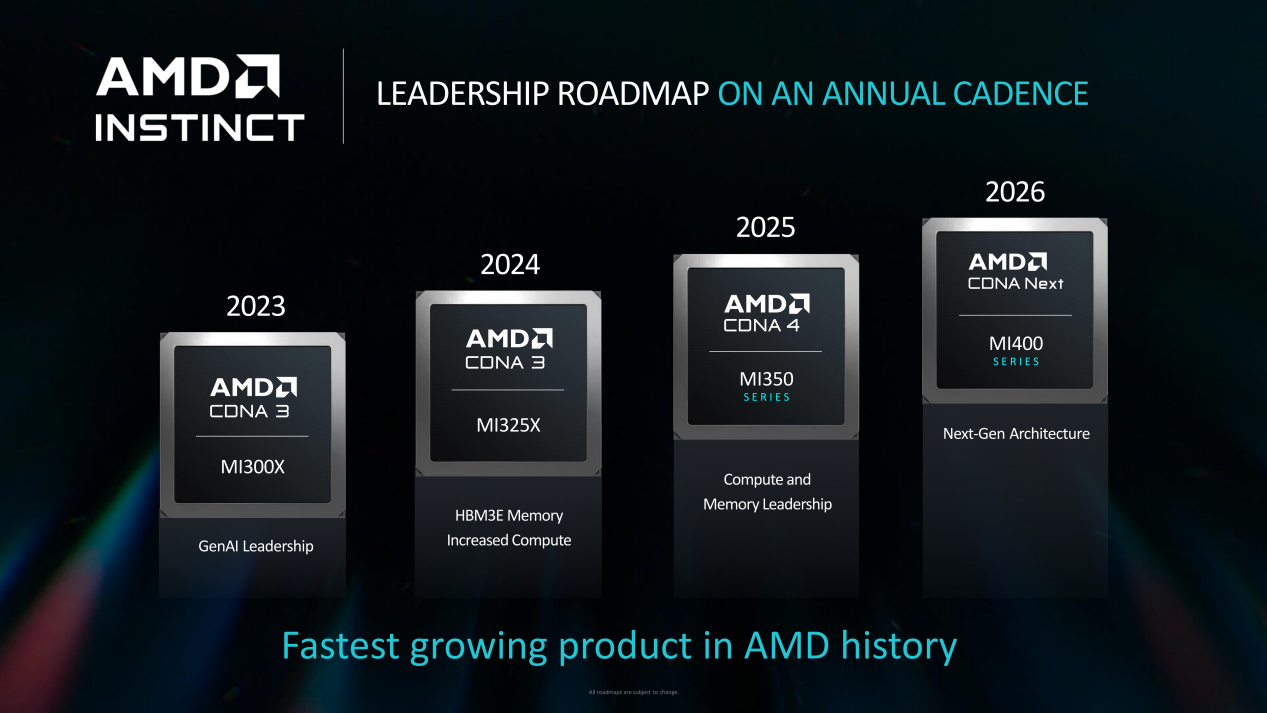

在本次Advancing AI 2024大会上,AMD也公布了Instinct的路线图,并预计将于2026年推出下一代CDNA架构的MI400系列AI加速卡。

在本次Advancing AI 2024大会上,AMD也公布了Instinct的路线图,并预计将于2026年推出下一代CDNA架构的MI400系列AI加速卡。

本文属于原创文章,如若转载,请注明来源:代际性能升级 强势对标H200 AMD公布Instinct MI325X/MI355X AI加速器https://nb.zol.com.cn/907/9071636.html