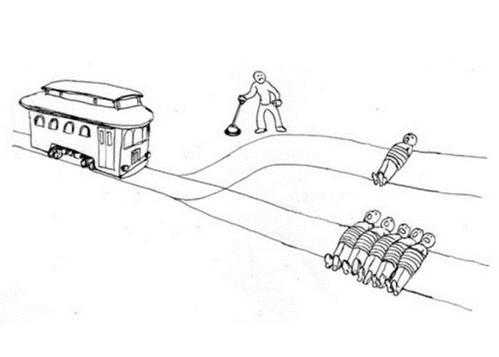

如果说“抢工作”这个问题还好理解,那么前面提到“先救谁”的伦理问题,可能部分朋友一头雾水。这个问题是目前研究自动驾驶技术必须要面临、且难以抉择的。

举个例子,如果一辆自动驾驶汽车疾驰在高速上,马上就要撞上前方的3名刚下车的乘客(因汽车故障下车),往左转向会撞上左侧载有2人的汽车,往右则会跌下山谷。此时紧急刹车也无济于事了, AI 会怎么选择。

AI 领域的世纪难题:电车难题

与其说 AI 如何选择,不如说 AI 背后的工程师如何选择。在紧急状态下,人躲避自身伤害的本能是最强烈的,尤其是千钧一发的情况下,很难做出理性的判断;但人又是有责任的,在遇到小孩、孕妇或者老人的时候也会出现本能闪避的行为。所以在这种条件下,不同人群在道德困境下的反应是千差万别的,造成的后果也不尽相同。

但到了 AI 上就不一样了,工程师担当着“上帝”的角色, AI 做出的决定事实上是工程师编码的结果,可以理解为是工程师“授权” AI 这么做的。那么“造成的后果是否需要背后的工程师承担”、“车内乘客应不应该冷眼旁观整个过程”等类似的道德问题便接踵而来。

目前针对类似问题,研究自动驾驶技术的车企也不能给出合理的解决方案,因为技术层面的问题可以解决,但道德层面的问题是无解的。目前算得上是诚实的答案也只能是:由于车主是车企的客户,车企会优先保护客户的权益,即优先保护车内人员的安全。

所以结论是残酷的,如果无法避免人员伤亡的话,无论前方是孩子、孕妇还是老人,以目前的逻辑, AI 都会优先保护车内乘客的安全。

除了自动驾驶领域,在技术还没有突破之前, AI 面临着太多相似的伦理困境,比如医疗、教育以及司法等行业,而如何解决这些伦理困境,最终还是归结到工程师的取舍上,恐怕没有哪位工程师敢直言能够承担这样的社会责任和压力。

本文属于原创文章,如若转载,请注明来源:从年初火到年末的AI 或许我们真的应该敬畏它//nb.zol.com.cn/670/6701558.html