01锐龙AI 300大语言模型测试

产品:16+ 2025 锐龙AI元启版(AI 9 365/32GB/1T ThinkBook 笔记本电脑自GPT-2以来,语言模型已经取得了长足的进步,用户现在可以通过LM Studio等用户友好的应用程序快速轻松地部署高度复杂的大语言模型(LLM)。通过和AMD协作,这些工具致力于使每个人都可以使用AI,而不需要编码或技术知识。

llama.cpp和LM Studio概述

LM Studio基于llama.cpp项目,是当前非常流行的快速部署语言模型的框架。它没有依赖性,可以仅使用CPU进行加速——尽管它也有GPU加速功能。LM Studio使用AVX2指令来加速基于x86的CPU的现代大语言模型。

性能对比:吞吐量和延迟

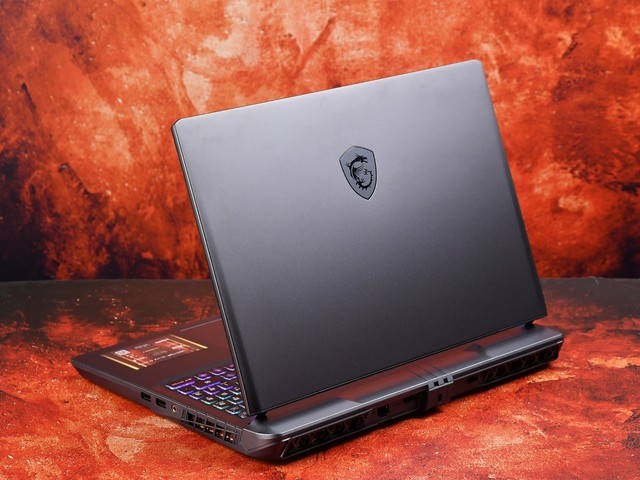

AMD锐龙AI为这些最先进的工作负载进行加速,并在基于llama.cpp的应用程序(如用于x86笔记本电脑的LM Studio)中提供了领先的性能。值得注意的是,大语言模型通常对内存速度非常敏感。

在我们的对比测试中,英特尔笔记本电脑的RAM实际上更快,达到8533MT/s,AMD笔记本电脑的RAM为7500MT/s。尽管如此,AMD锐龙AI 9 HX 375处理器每秒token生成速度却比竞争对手快出27%。

【参考信息:每秒token生成量或tk/s表示一个大语言模型(LLM)能够以多快的速度输出token(大致对应于每秒在电脑屏幕上显示的单词数)。】

AMD锐龙AI 9 HX 375处理器可以在Meta Llama 3.2 1b Instruct(4-bit量化)中实现每秒高达50.7个token的性能。

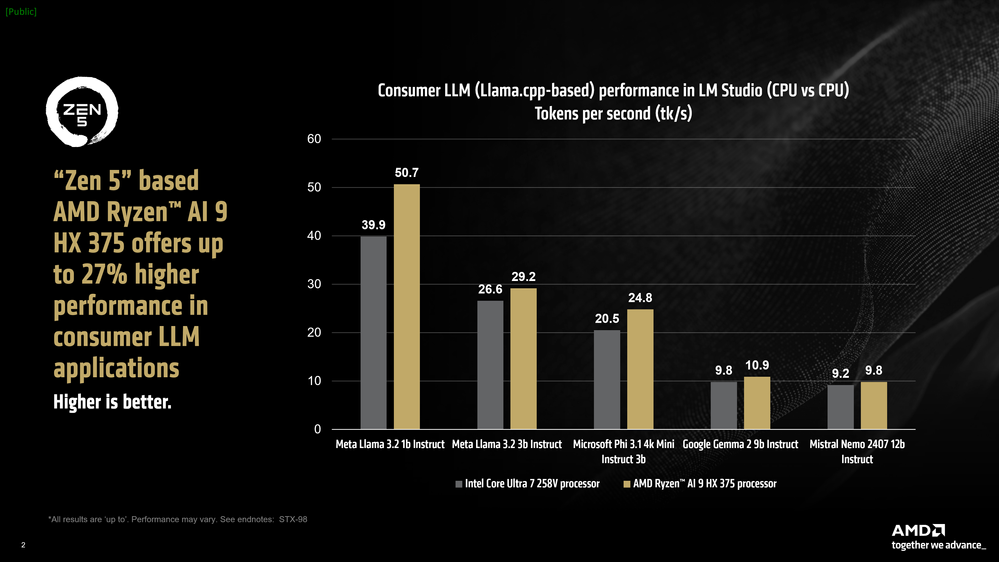

对大型语言模型进行基准测试的另一个指标是“输出首个token的时间”,它测量了从您提交提示到模型开始生成token所需时间之间的延迟。在这里,我们看到,在较大的模型中,基于AMD“Zen 5” 架构的锐龙AI HX 375处理器比竞争对手的同类处理器快3.5倍。

在Windows中使用可变显存(VGM)来加快模型吞吐量

AMD锐龙AI CPU中的三个加速器都有自己的工作负载专业化和它们擅长的场景。AMD基于XDNA 2架构的NPU在运行Copilot+工作负载时为持续的AI功能提供了令人难以置信的能效,CPU为工具和框架提供了广泛的覆盖范围和兼容性,而iGPU通常按需处理AI任务。

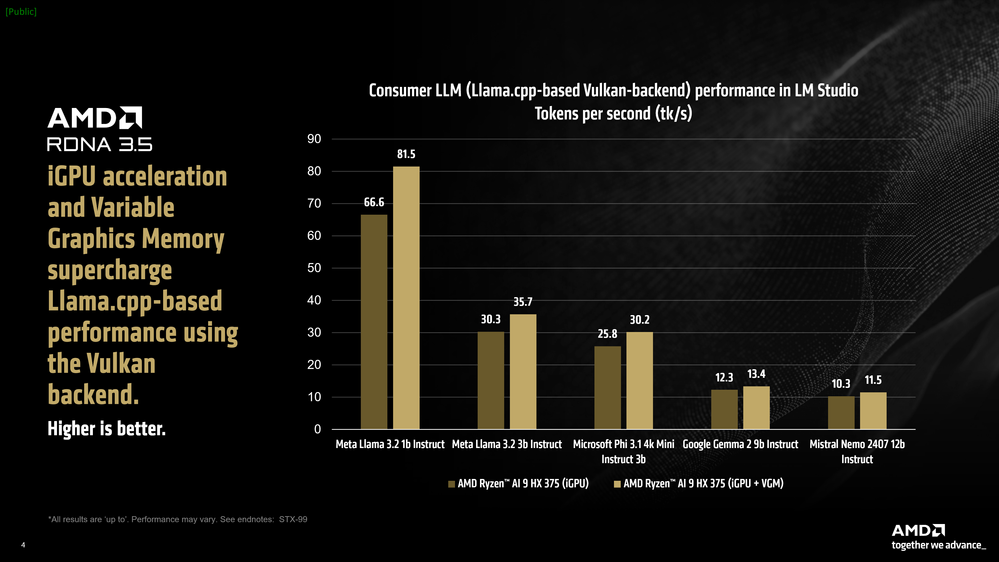

LM Studio提供了一个llama.cpp端口,可以使用与供应商无关的Vulkan API来加速框架。这里的加速通常取决于硬件功能和Vulkan API的驱动程序优化。与仅使用CPU模式相比,在LM Studio中打开GPU offload 后Meta Llama 3.2 1b Instruct的性能平均提升可达31%。像Mistral Nemo 2407 12b Instruct这样的大型模型在token生成阶段由于受到带宽限制,平均提升可达5.1%。

我们观察到,当在LM Studio中使用基于Vulkan的llama.cpp版本并打开GPU offload时,与仅使用CPU的模式相比,竞争对手的处理器在除一个模型外的所有测试模型中的平均性能都明显较低。因此,为了保持对比测试的公平性,我们没有将英特尔酷睿Ultra7 258v在LM Studio中使用基于Vulkan的Llama.cpp的GPU offload性能纳入对比过程。

AMD锐龙AI 300系列处理器还包括一个名为可变显存(VGM)的功能。通常,程序将利用iGPU的512MB专用分配内存块以及位于系统RAM“共享”部分的第二个内存块。VGM允许用户将512MB专用分配块扩展到高达75%的可用系统RAM容量。这种连续内存分配显著提高了内存敏感型应用程序的吞吐量。

在开启VGM(16GB)后,我们看到Meta Llama 3.2 1b Instruct的性能平均提升了22%,与使用iGPU加速和VGM相结合时的CPU模式相比,平均速度总共提高了60%。即使是更大的模型,如Mistral Nemo 2407 12b Instruct,与仅使用CPU的模式相比,性能也提升了17%。

对比:Mistral 7b Instruct 0.3

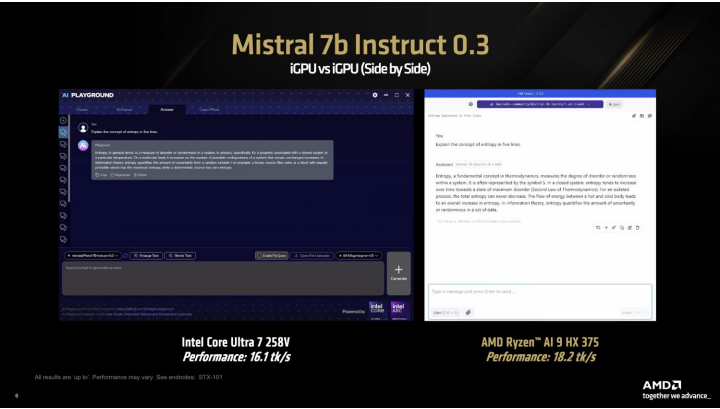

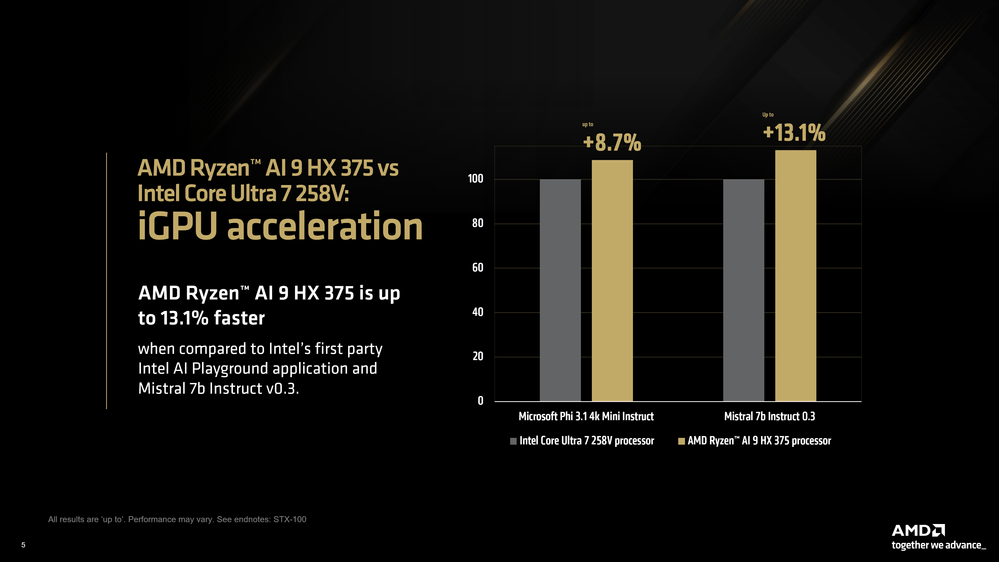

虽然竞争对手的笔记本电脑在LM Studio中使用基于Vulkan的Llama.cpp版本没有提供加速,但我们使用英特尔AI Playground应用程序(基于IPEX-LLM和Lang Chain)比较了iGPU性能,力求在最佳的用户友好型LLM体验之间进行公平的比较。

我们使用了英特尔AI Playground提供的模型,即Mistral 7b Instruct v0.3和Microsoft Phi 3.1 Mini Instruct。在LM Studio中使用可比的量化后,我们发现AMD锐龙AI 9 HX 375在Phi 3.1中的速度相比竞争对手快了8.7%,在Mistral 7b Instruct 0.3中的速度相比对手快了13%。

AMD致力于推进AI前沿技术的发展,让每个人都能使用AI,但如果最新的AI成果被技术或编码技能等高门槛所限制,那这一切就不可能发生——这就是LM Studio这样的应用程序的重要性所在。除了作为在本地部署LLM的一种快速而轻松的方式之外,这些应用程序允许用户在第一时间体验最先进的模型(前提是llama.cpp项目支持该架构)。

AMD锐龙AI加速器提供了令人难以置信的性能,启用可变显存(VGM)等功能可以为AI用例提供更好的性能。所有这些结合在一起,为x86笔记本电脑上的语言模型提供了令人难以置信的用户体验。